Deep Learning/2023 DL 기초 이론 공부

[밑바닥부터 시작하는 딥러닝 2] chap5(순환 신경망 RNN)

제룽

2023. 7. 9. 00:51

728x90

반응형

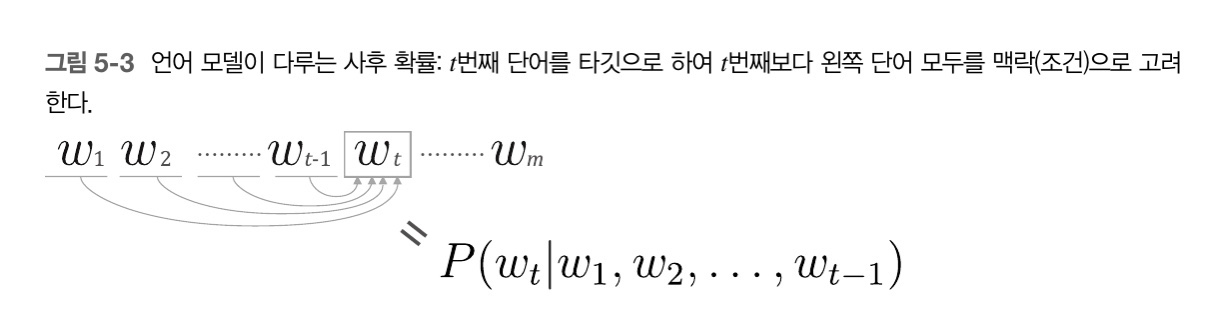

5.1 확률과 언어 모델

1. 언어모델

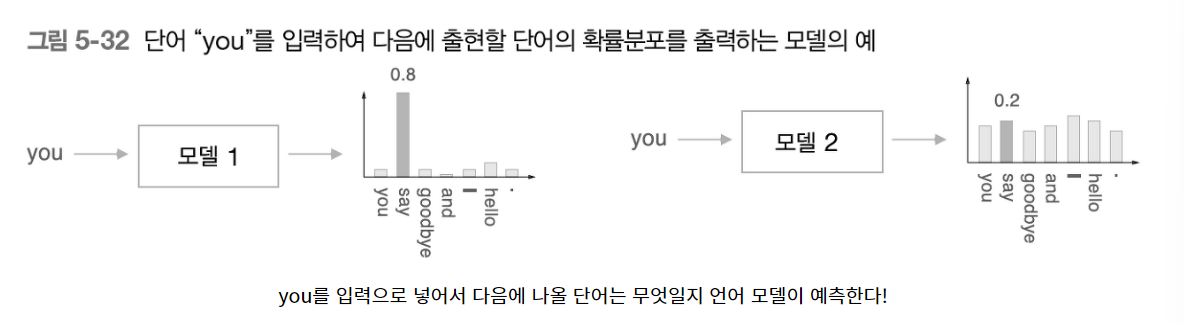

- 단어 나열에 확률을 부여

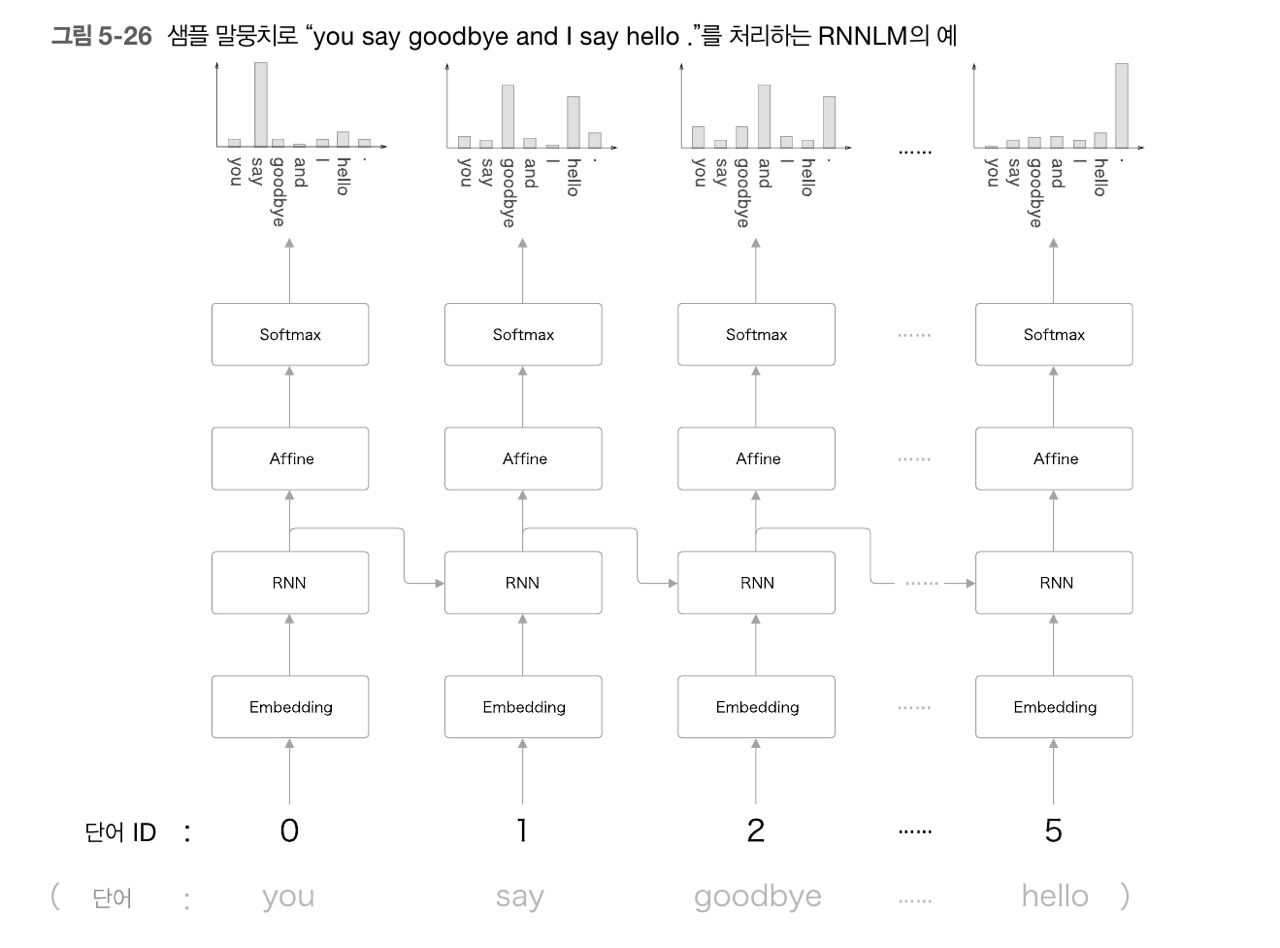

- 특정한 단어의 시퀀스에 대해 그 시퀀스가 일어날 가능성이 어느 정도인가(얼마나 자연스러운 단어 순서인지)를 확률로 평가하는 것.ex) you say goodbye ⇒ 0.092 but, you say good die ⇒ 0.0000000032

- 사용 예시: 기계 번역 및 음성 인식에 주로 사용, 새로운 문장 생성 용도

- CBOW와 달리 왼쪽 윈도우만 맥락으로 고려함.

- 즉, 언어모델은 변경된 수식처럼 t-2번째 단어, t-1번째 단어가 발생했을 때, 다음 순서로 나올 단어인 t번째 단어가 무엇으로 나올지 예측하는 모델을 의미.

- 다음 순서에 나올 단어의 자연스러움을 하나의 확률 지표값으로 예측.

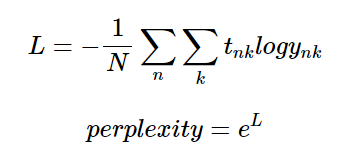

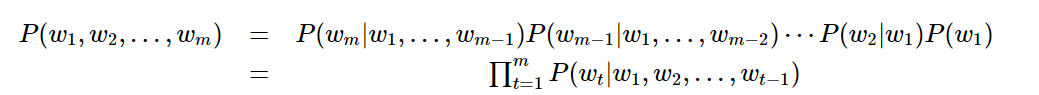

- 동시 확률이란: m개의 단어가 있다고 가정할 때, 단어가 m 순서로 발생할 확률을 P(w1,w2,,,,wm)으로 정의한 것

- 사후 확률의 총 곱 = 동시 확률 (특정 사건 발생 후에 다른 사건이 발생할 확률 ⇒ 사후확률)

- P(wt| w1,w2,,,,,,wt-1) 을 조건부 언어 모델이라고 함.

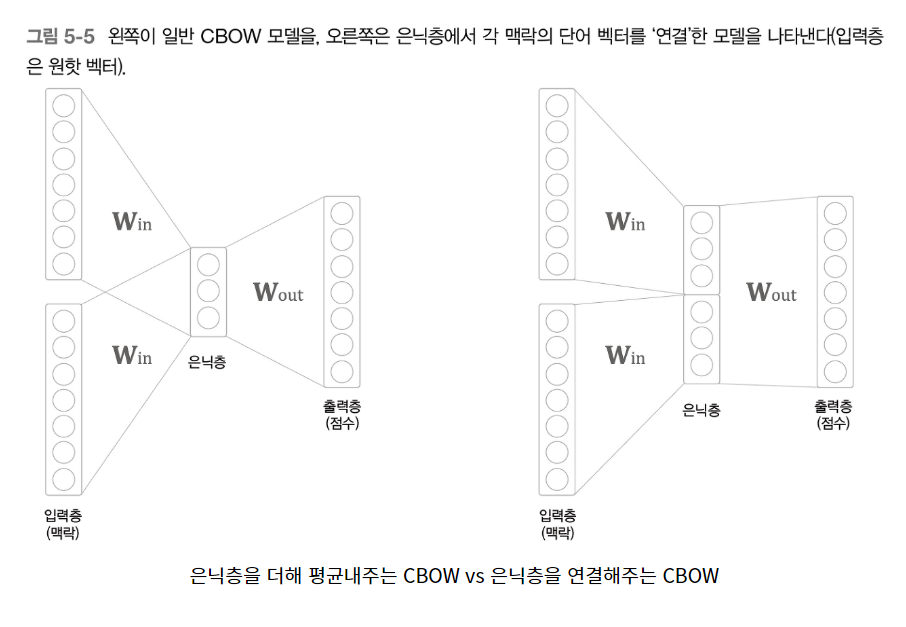

- 직전 2개에만 의존한다고 하면 2층 마르코프 체인이라고 함( 직전 N개에만 의존한다고 하면 N층 마르코프 체인이라고 함)

- 하지만 이는 단어의 순서를 무시하게 됨.ex) Tom was watching TV in his room. Mary came into the room. Mary said hi to (?)

- 라고 가정했을 때 문맥상 Tom이 나와야 함. 하지만 직전 단어 2~10개만을 가지고 할 경우, Tom을 기억하지 못함.

- 따라서 오른쪽과 같이 데이터의 input값을 순서대로 붙여줘야 함.(연결)

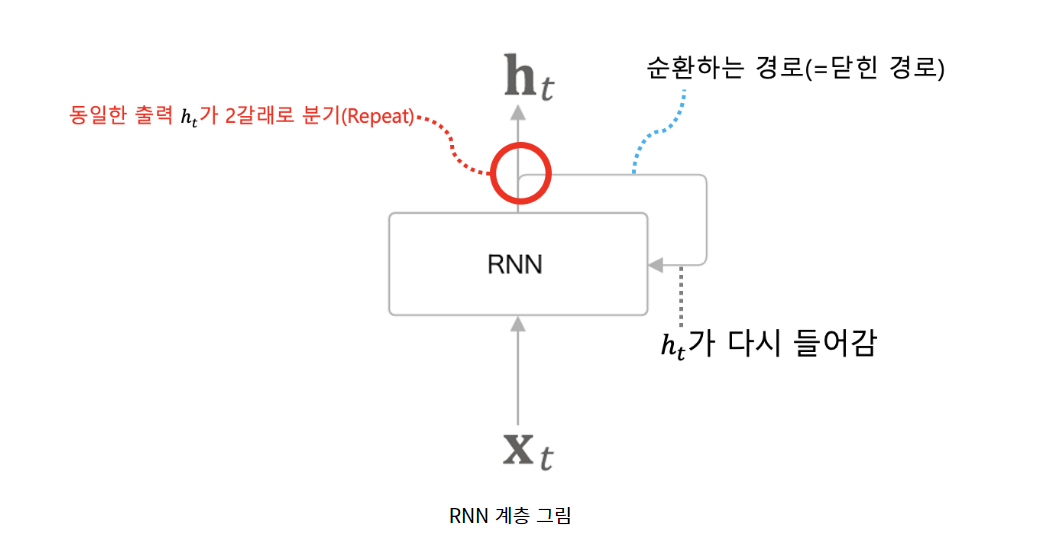

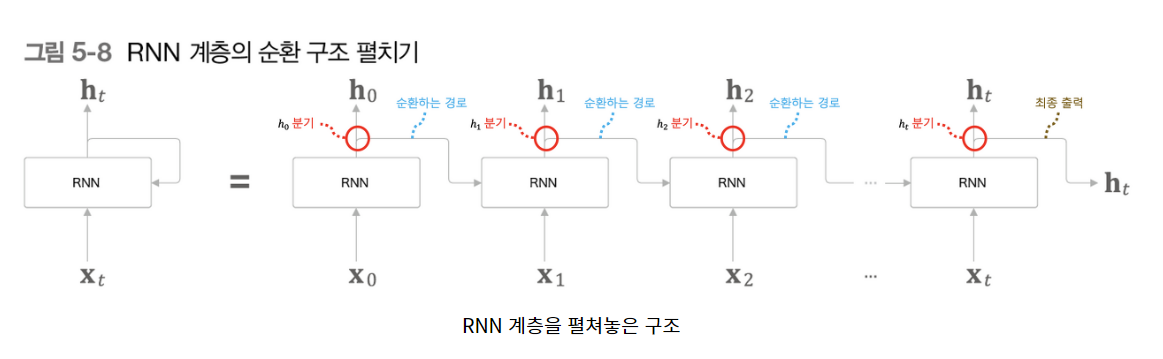

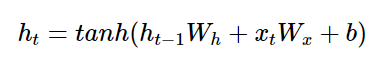

5.2 (순환신경망) RNN이란

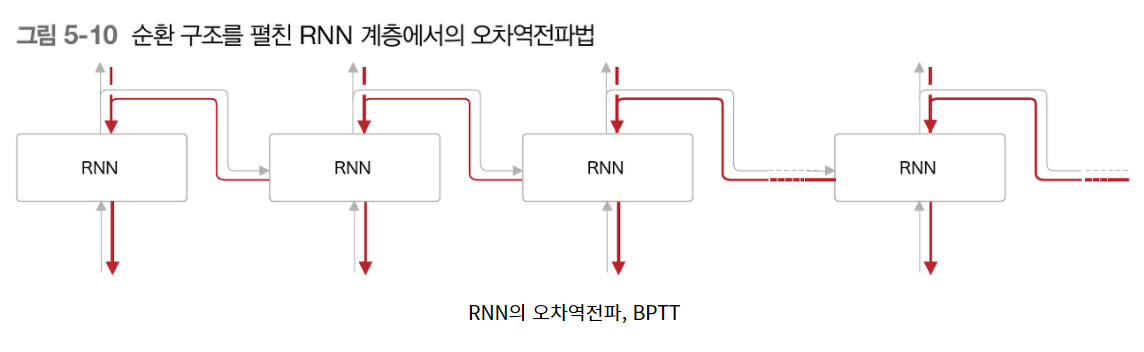

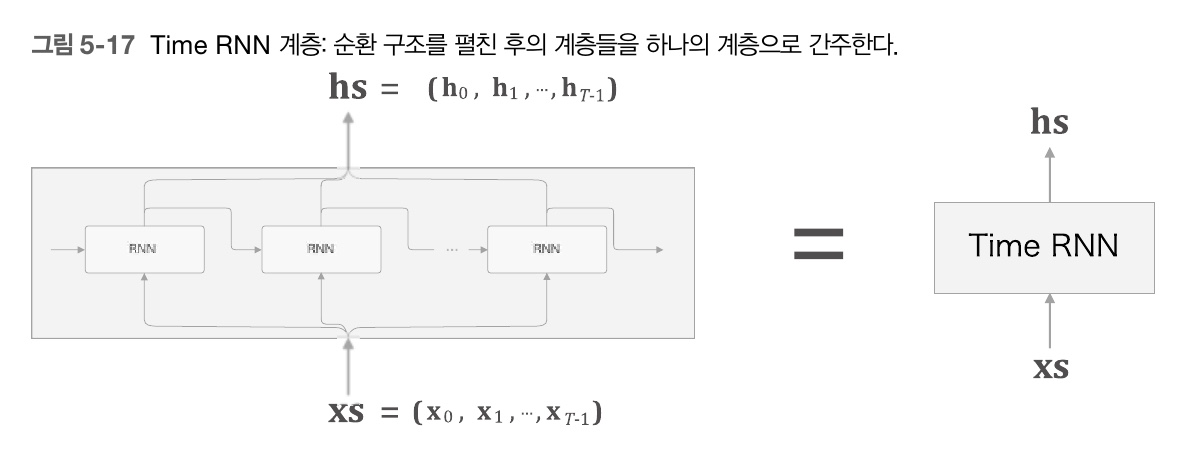

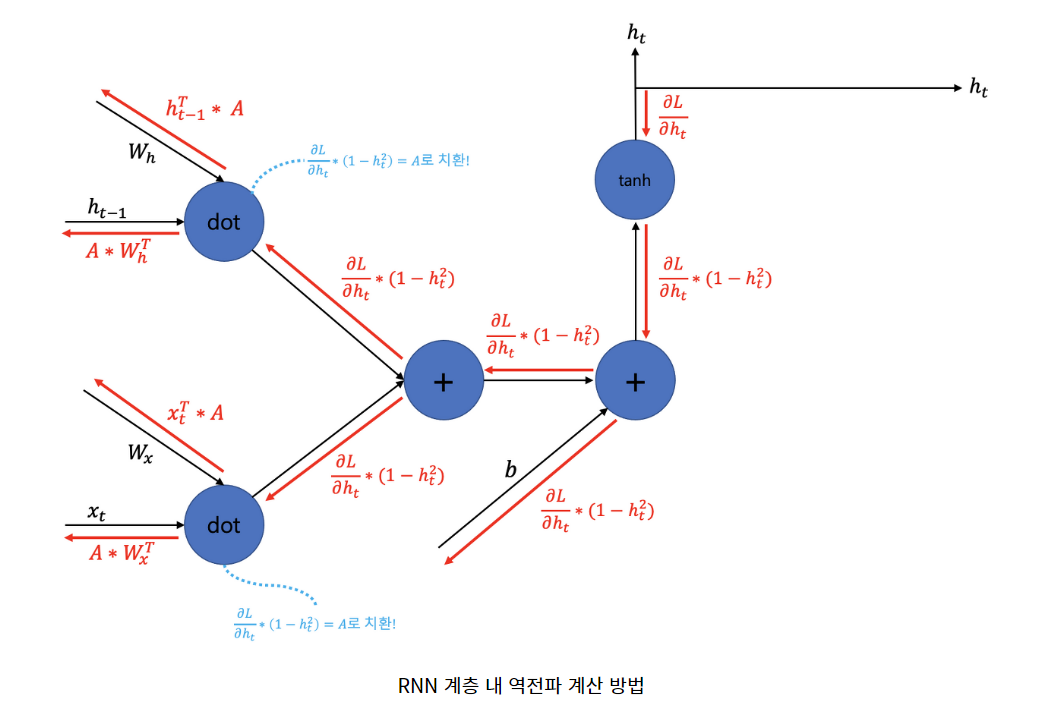

5.3 RNN 구현

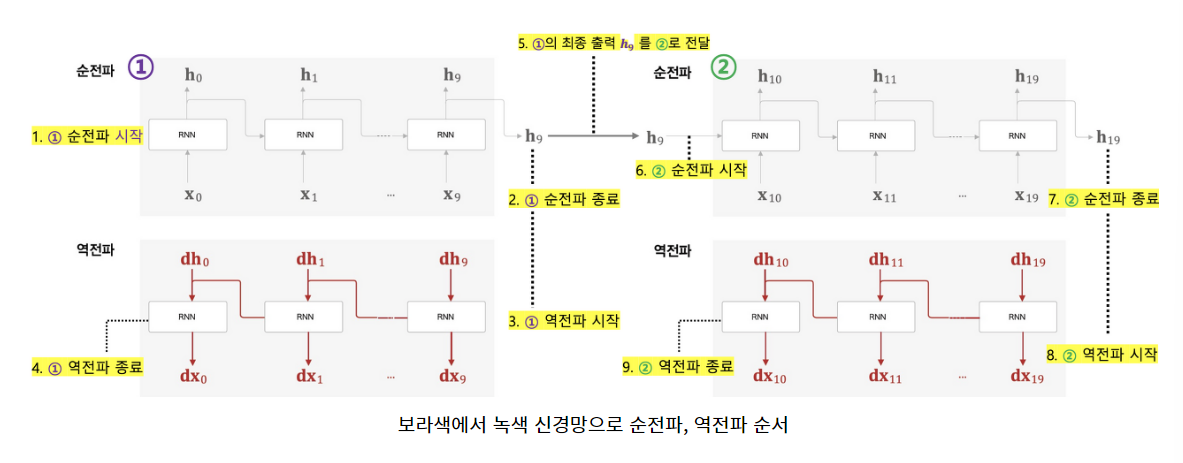

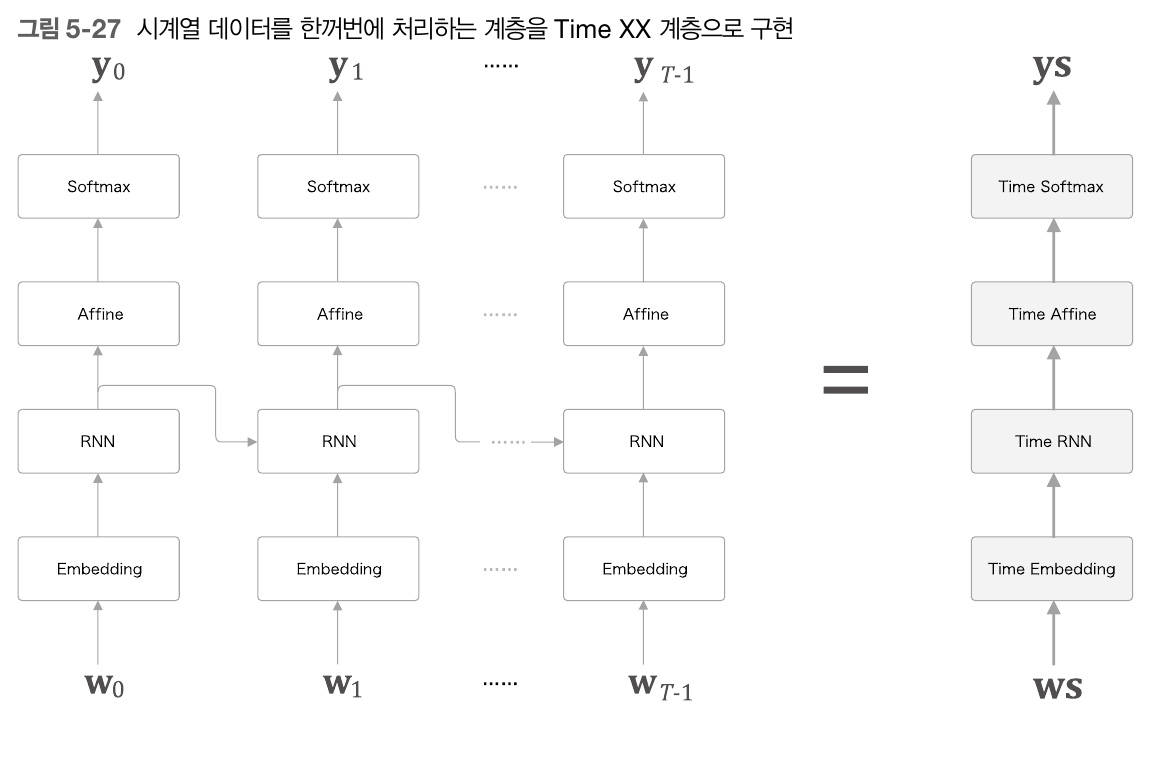

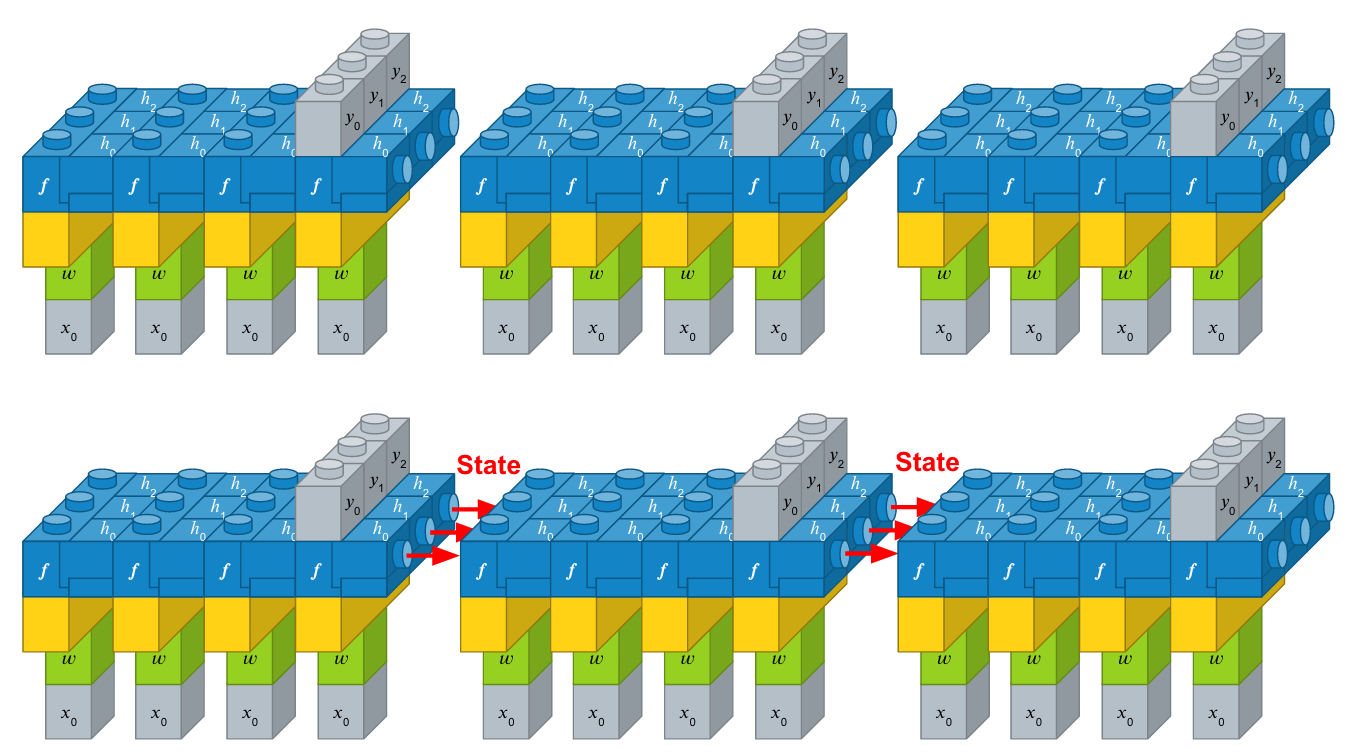

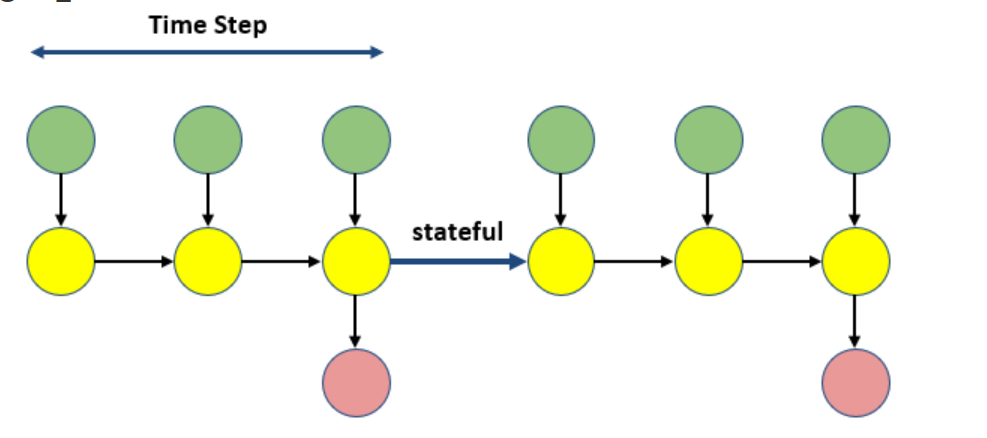

- T개 단계분의 작업을 한꺼번에 처리하는 계층 : Time RNN 계층

class TimeRNN: """ 단일 RNN 계층이 T개 있는 TimeRNN 계층 구현 Args: Wx: 입력 벡터 x에 곱해지는 파라미터 Wh: 이전 RNN 계층으로부터 흘러들어오는 은닉 상태 벡터 h에 곱해지는 파라미터 b: 편향 파라미터 stateful: 은닉 상태를 유지할지 여부. 유지하면 Truncated BPTT 수행하면서 순전파를 끊지 않고 전달 """ def __init__(self, Wx, Wh, b, stateful=False): self.params = [Wx, Wh, b] self.grads = [np.zeros_like(Wx), np.zeros_like(Wh), np.zeros_like(b)] self.layers = [] # 여러개의 단일 RNN 계층을 저장할 리스트 self.h = None # 다음 신경망 블록에 넘길 이전 신경망의 마지막 은닉 상태 벡터 self.dh = None # 이전 블록의 은닉 상태 기울기 값(이는 Truncated BPTT에서는 필요없지만 seq2seq에서 필요하기 때문이라고 함) self.stateful = stateful # 은닉 상태를 설정하는 함수 def set_state(self, h): self.h = h # 은닉 상태를 초기화하여 은닉 상태 유지를 끊어버리는 함수 def reset_state(self): self.h = None def forward(self, xs): """ xs라는 T 길이의 시계열 전체 입력 벡터를 순전파 수행 Args: xs: T 길이의 시계열 전체 입력 벡터 """ Wx, Wh, b = self.params N, T, D = xs.shape # (batch_size, time length, 입력벡터 차원 수) D, H = Wx.shape # (입력벡터 차원 수, 은닉 상태 벡터 차원 수) self.layers = [] # T길이의 RNN 계층 전체의 은닉 상태 벡터를 담을 배열 초기화 hs = np.empty((N, T, H), dtype='f') # 순전파 유지 끊을 경우 if not self.stateful or self.h is None: self.h = np.zeros((N, H), dtype='f') for t in range(T): layer = RNN(*self.params) self.h = layer.forward(xs[:, t, :], self.h) # loop 다 돌고 마지막에 self.h에는 해당 블록의 최종 은닉 상태 벡터 들어있음 hs[:, t, :] = self.h self.layers.append(layer) return hs def backward(self, dhs): """ T길이의 시계열 전체를 한 번에 역전파 수행 Args: dhs: T길이 시계열 내의 모든 은닉 상태 벡터의 기울기 """ Wx, Wh, b = self.params N, T, H = dhs.shape D, H = Wx.shape dxs = np.empty((N, T, D), dtype='f') # T길이 시계열 내의 모든 입력 벡터의 기울기 dh = 0 grads = [0, 0, 0] # 하나의 RNN 계층에서의 Wx, Wh, b 파라미터의 기울기 담을 리스트 for t in reversed(range(T)): layer = self.layers[t] # 각 RNN 계층 당, 순전파 시 은닉상태 h 벡터가 두 갈래로 분기되었으므로 역전파 시에는 기울기를 sum! dx, dh = layer.backward(dhs[:, t, :] + dh) dxs[:, t, :] = dx # 하나의 RNN 계층에서의 Wx, Wh, b 파라미터의 기울기 담기 for i, grad in enumerate(layer.grads): grads[i] += grad # T길이 시계열 전체의 RNN 계층에 걸쳐서 만들어진 Wx, Wh, b 파라미터의 기울기 담기 for i, grad in enumerate(grads): self.grads[i][...] = grad self.dh = dh # 역전파 방향으로 했을 때, 마지막 은닉 상태 벡터의 기울기 값 저장 for seq2seq return dxs- stateful= True 지정된 한 바퀴(Time step)가 종료된 이후에도 상태를 초기화 하지 않고, 다음 바퀴에 초기 상태로 사용한다.

- 은닉상태를 유지하는 것 ( 이전 시각의 은닉 상태를 유지할지 말지 지정)

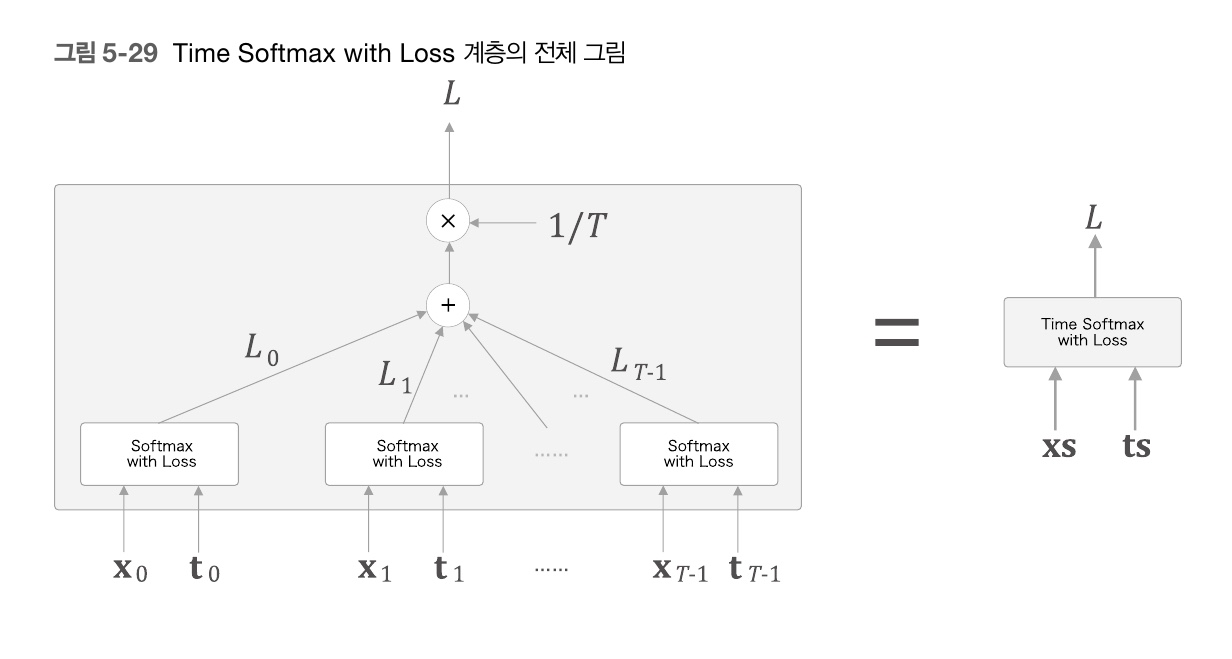

5.5 RNNLM 학습과 평가

728x90

반응형