1. Activation Functions

- 활성화 함수: 출력값을 활성화를 일으키게 할 것인가를 정하고 그 값을 부여하는 함수.

- 사용하는 이유: Data를 비선형으로 바꾸기 위함

- 왜 비선형으로 바꾸는가?: 복잡한 모델을 만들기 위해서⇒ 선형함수의 경우, 망이 깊어지지 않는다는 단점이 존재. 아무리 복잡하게 만든다고 해도 ex) h(x)= cx(일차함수) ⇒ 3-layer ⇒ y(x)=h(h(h(x))) ⇒ y(x)=c^3x로 밖에 안됨. 결국 같은 선형 함수임.따라서, 뉴럴네트워크에서 층을 쌓는 혜택을 얻고 싶다면, 활성화함수로는 반드시 비선형 함수를 사용.

- 활성화 함수를 사용하면 입력이 들어갈 때, 출력값이 선형으로 나오지 않기 때문에 망을 깊게 만들 수 있다는 장점 존재.

- ⇒ 결국 linear한 연산을 같은 layer을 수십개 쌓아도 하나의 선형 연산으로 밖에 나타낼 수 없음. ⇒ hidden layer가 한 줄만 존재하게 됨. (복잡도x)

1. Sigmoid 함수

- 단일, 이진 분류에서 많이 사용됨

문제점 1

- 음/양의 큰값에서 Saturation되는 것이 gradient를 없앤다. (기울기소실)

- x가 0에 가까운건 잘 동작함

문제점 2

- 출력이 zero centered가 아니다

- 만약 x가 항상 양수일 떄, w의 gradient는 시그모이드 upstream gradient와 부호가 항상 같게 된다. 이는 W로 하여금 모두 양의 방향이나, 모두 음의 방향으로밖에 업데이트가 되지 못하게 하기 때문에, zig zag path를 따름 ⇒ 비효율적

⇒ 파란색 화살표가 최적의 업데이트지만 빨간색으로만 움직임 ⇒ 오래 걸림

- 자 이말이 무엇이냐, 손실함수를 통해 역전파를 하게 되는데, 이때 손실함수가 양수나 음수냐에 따라서 방향이 결정되는 것임

- 시그모이드의 기울기는 다 양수이기 때문에, 손실함수의 값이 양이ㅑ 음이냐에 따라서 한쪽으로 밖에 업데이트가 안된다는 것을 의미하기도 함.

- 즉, 손실함수가 양수이면 양수로만, 손실함수가 음수면 음수로만

- 따라서 지그재그가 형성된다는 것을 의미하기도 함.

문제점 3

- exp() 가 연산 cost가 비쌈

2. tanh 함수

- sigmoid의 zero centered 문제 해결.⇒ 기울기 소실과 exp 연산 문제 남음

이때 zero centered가 해결되면 좋은점 ⇒ 앞의 sigmoid 같은 경우, 인풋과 가중치가 곱해진 값을 시그모이드에 넣게 되면 0~1 사이 값으로 변환 시켜버림 (output) → 무조건 양의 값만 나오게 되므로 앞의 기울기가 양수냐 음수냐에 따라서 값이 하나로 정해짐

하지만 탄젠트의 경우 데이터 중심을 0으로 위치 시킴.

그러게 될 경우 손실함수 값을 구하게 되어도 -값부터 양수 값까지 다양하게 존재ㅇㅇ

그렇기 때문에 한정적인 학습에서 좀 더 수월한 학습이 일어나게 됨ㅇㅇ

⇒ 양부터 음값 까지 다양하게 ⇒ 미분해도 양부터 음값까지 다양하게 존재.

⇒ 즉, 이전의 기울기가 양수든지 음수든지 기울기 값이 다양하게 나오게 됨.

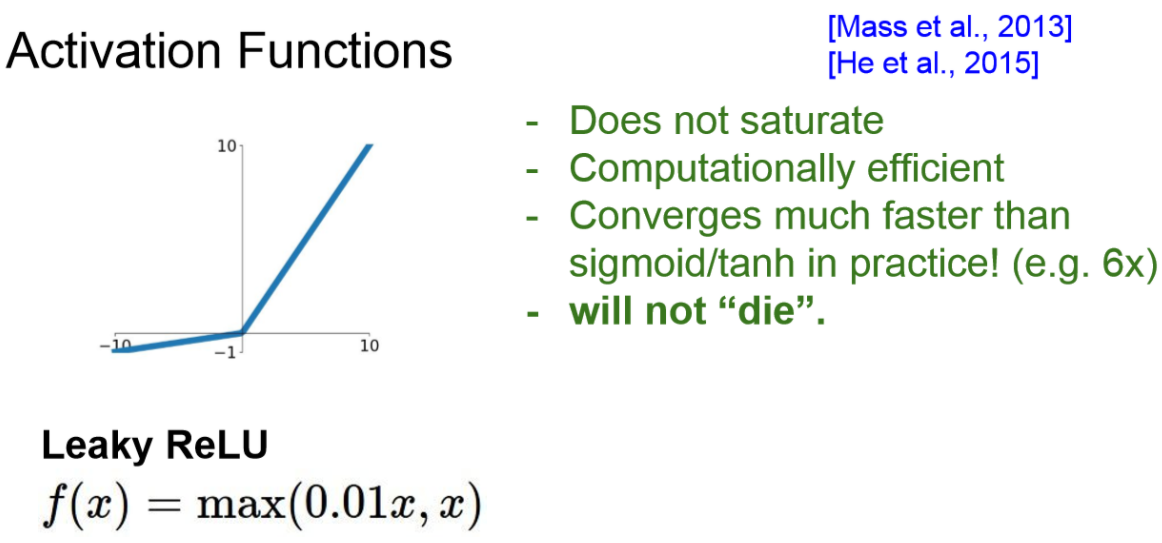

3. ReLU 함수

6. ELU

8. Activation 결론

2. Data Preprocessing

- 데이터 전처리 ⇒ zero-centered, 정규화를 많이 사용

- 이미 이미지가 0~255로 제한 되어 있어서 정규화 사용x zero만 사용한다고.

PCA와 Whitening 기법도 있다고하는데 image에서는 잘 쓰이지 않는다고 합니다.

- Principal Component Analysis(PCA)

- 데이터를 정규화 시키고 공분산(Covariance) 행렬을 만듭니다.

- 공분산 행렬이란 각 구조간 상관관계를 말해주는 행렬입니다.

- SVD factorization으로 상위 중요한 몇 개의 vector들만 이용하여 차원을 축소하는데 사용할 수 있습니다.

- Whitening

- input의 feature들을 uncorrelated하게 만들고, 각각의 variance를 1로 만들어줌

- 기저벡터 (eigenbasis) 데이터를 아이젠벨류(eigenvalue)값으로 나누어 정규화 하는 기법입니다.

- 이 변환의 기하학적 해석은 만약 입력 데이터의 분포가 multivariable gaussian 분포 라면 이 데이터의 평균은 0, 공분산은 단위행렬(I)인 정규분포를 가집니다.

3. Weight initialization

모든 파라미터를 0으로 설정한다면?

Gradient vanishing발생

- 모든 뉴런이 같은일을 한다

- 모든 가중치가 똑같은 값으로 업데이트됨

- 모든 가중치를 동일하게 초기화시키면 symmetry breaking이 일어날 수 없다.

- 서로 다른 loss를 가질 수 있으나 많은 뉴런들이 동일한 가중치로 연결되어 있을것이며, 모든 뉴런이 같은 방식으로 업데이트 될 것이다.

4. Batch Normalization

- 가우시안(정규)분포 범위에서 활성화 함수가 꾸준히 잘 이루어지는 것을 목표로 함.

- 그래서 나온 기법이 batch 정규화

- 학습하는 과정을 전체적으로 안정시켜주는 것.

- activation 전에 잘 분포되도록 한 후에 activation 진행할 수 있도록 해줌

- 그래서 순서가 저렇게 되는 것.

- 의문점

- Activation function을 relu를 사용한다면?

- 가중치의 크기를 증가시킬때 더 나은 성능을 가진다면?

감마 값으로 BN의 Variance 값을 조절하며, 베타 값으로 평균 값을 조절할 수 있게됩니다.참고로감마 값이 표준편차이고,베타가 평균 값이면BN를 하지 않는 것과 같습니다.감마:Scaling

베타:Shifting

- 그리고 이 감마와 베타 값을 학습의 Hyperparameter로 사용하여 알맞은 값을 얻어가도록 합니다.

- 이러한 문제를 해결하기 위해서 여기서 감마와 베타 값이 주어지게 됩니다.

- +++

보통 BN을 하면 Dropout을 안써도 된다고 합니다.

그 이유는 Dropout은 랜덤하게 값을 꺼내주기 때문입니다.

BN도 마찬가지로 배치마다 값이 조금씩 다르게 들어가고 값이 계속 바뀌게 되어 노이즈가 적어지게 된다고 합니다.

또한 BN은 선형변환으로 기존의 공간적인 구조가 잘 유지됩니다.

Notice) CONV에서 Batch Normalization 할때 주의사항

- 기존에 Wx + b 형태로 weight를 적용해 주는데 BN의 Beta 값과 중복된다.

- 고로 Wx + b 의 bias 값을 사용하지 않아도 된다.

- 장점

- Network에

Gradient flow를 향상시킴

높은 learning rate를 사용해도 안정적인 학습가능

Weight 초기화의 의존성을 줄임

Regularization기능도 하여dropout의 필요성을 감소시킴

Test 시에 overhead가 없다. (학습된 것을 사용만 함)

- Network에

- Test할땐 Minibatch의 평균과 표준편차를 구할 수 없으니

Training에서 구한 고정된 Mean과 Std를 사용함

5. Babysitting the Learning Process

- 데이터 전처리

- 아키텍쳐 선택

- 네트워크 초기화

- 초기 loss 체크

- soft max라면 로그 체크, 이후 regularization term 추가후 loss 증가 체크

- 데이터 일부만 학습시켜보기

- regularization 사용 x

- epoch마다 loss 내려가는지 확인, train accuracy 증가 확인

- learning rate 정하기

- regulaization 약간만 주고 learning rate 찾기

- learning rate가 작으면 gradient 업데이트가 충분히 일어나지 않아 loss가 잘안줄어듬

- 너무 크면 NaNs cost발산

- 보통 e-3 e-5 사이 사용

6. Hyperparameter Optimization

cross-valindation은 training set으로 학습시키고 validation set으로 평가하는 방식

- coarse stage: epoch 몇번으로 좋은지 아닌지 판단 -> 범위 결정

- 로그 스페이스에서 차수 값만 샘플링하는게 좋다

- fine stage: 학습 좀 더 길게

- train 동안 cost 변화를 읽자. 이전 cost보다 더 커지거나 3배 높아지거나 하면 NaNs 나옴. 엄청 빠르게 오르면 멈추고 다른거 선택

- 여기서 말하는 cost가 뭔지?

- reg범위, lr 범위 정함

- 최적 값이 범위의 중앙 쯤에 위치하도록 범위를 설정

- random search를 사용하면 important variable에서 더 다양한 값을 샘플링 할 수 있어 좋다

loss curve

- 평평하다가 갑자기 가파르게 내려감-> 초기화 문제

= gradient의 역전파가 초기에는 잘 되지 않다가 학습이 진행되면서 회복

train과 va accuracy가 큰 차이면 오버핏 -> regularization의 강도 높이기

gap이 없다면 아직 overfit하지 않은 것이고 capacity를 높일 여유있는 것