part5-1 Data & Task: 어떤 데이터가 있을까

- 자연어 처리(NLP) : text 데이터를 분석하고 모델링 하는 분야 (NLU+NLG)

- 자연어 이해(NLU): 자연어 이해하는 영역

- 자연어 생성(NLG): 자연어 생성

- 감정분석 (sentiment analysis)

- 요약(summarization)

- 기계 번역(machine translation)

- 질문 응답(question answering)

- +a (품사 예측 분야, 챗봇 연구, 문장 간의 논리적 관계에 대한 분류 모델, 중의적 표현 구별, 이미지 속 상황 설명 글 만들기 등등

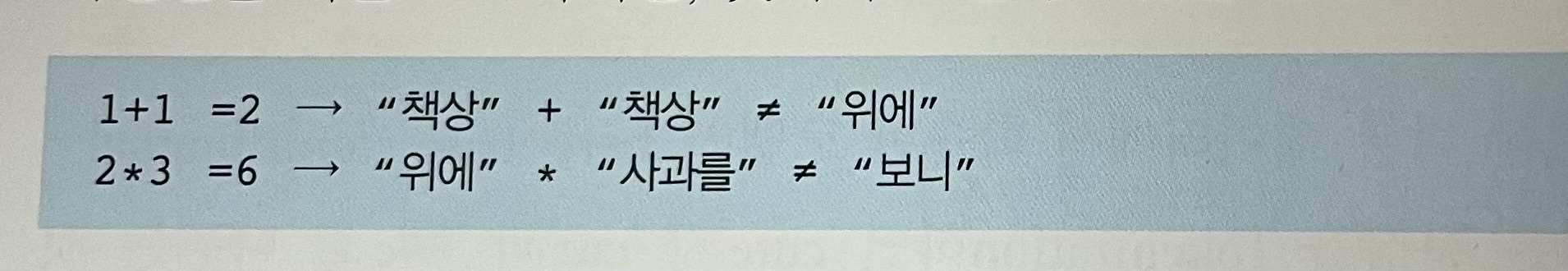

part5-2 문자를 숫자로 표현하는 방법

- Tokenization: 문장을 의미 있는 부분으로 나누는 과정

- 연속된 문자의 나열(문장)을 적절하게 의미를 지닌 부분의 나열로 바꾸는 과정

⇒ 여기서부터 여기까지의 문자의 나열은 특정 의미가 있는 부분이니 하나로 인식해라~

- 띄어쓰기

- 글자(Character)

Corpus & Out-of-Vocabulary(OOV)

- 저장해둔 vocabulary에는 Token이 없어서 처음 본 token이 나오는 현상

- 모르는 단어로 인해 문제를 푸는 것이 까다로워지는 상황을 OOV(Out-Of-Vocabulary) 문제라고 함

⇒ <unk>로 변환하는 것보다 예시 문장을 늘리기(corpus-말뭉치 데이터)

⇒ 결국 사전의 크기가 점점 커짐 ⇒ 모델 사이즈도 커지게 되는 문제점 발생

Byte Pair Encoding(BPE)

- 하나의 단어는 더 작은 단위의 의미 있는 여러 서브워드들(Ex) birthplace = birth + place)의 조합으로 구성된 경우가 많음

- 하나의 단어를 여러 서브워드로 분리해서 단어를 인코딩 및 임베딩(벡터로) 하겠다는 의도를 가진 전처리 작업

⇒ 이점: 사전의 크기가 줄어듬, oov 현상을 없앨 수 있음

1. Character based tokenization(글자를 토큰으로 활용하다)

- 글자: 최소의 단위(가~힣)

- 이점:

- 줄임말 및 신조어에 대해 걱정할 필요x ⇒ ㅇㅋㅇㅋ or ㄳ 까지로 나눔

- 사이즈 크기 크지 x

- 단점:

- 실제 딥러닝 모델에서 사용하는 token은 대부분 글자 단위가 아님.

- 표현법에 대한 학습이 어려움 ex) 글자 하나의 경우 특정의미를 갖지는 않음

→ ex) ‘핑’ or b 같은 글자 하나는 의미가 보통 없음

- 그렇기에 연속된 글자를 통해 특정 의미를 만들어 내야 함. ⇒ 하지만 이렇게 모델 만들기가 어려움

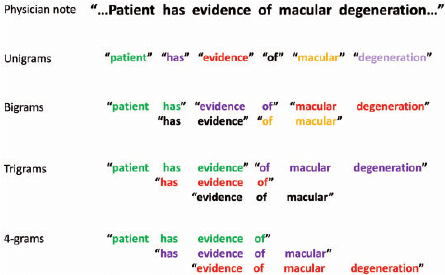

2. n-gram Tokenization

- 기존 글자를 통해 학습시키는 경우, 글자 하나하나의 의미는 거의 없기 때문에 글자의 특성 연속성이 의미를 가진 단어라는 것을 학습시켜야 함 → 이를 통해 문장과 같이 더 긴 형태의 글을 이해하도록 만들어야 함 → 비효율적

- 글자보다 더 긴 형태의 token을 만들자! 하고 나온 것이 n-gram 방식임.

이점:

- n-gram을 사용하게 되면 ex) ‘간 떨어질 뻔했다’ 와 같이 한번에 token을 뽑아낼 수 있음 → 이를 통해 ‘매우 놀라다’ 라는 의미를 한번에 만들어 낼 수 있음

단점:

- 쓸모없는 조합이 많이 생성됨.

- 사전이 과하게 커짐 (의미없는 뜻이나, 자주 사용되지 않는 token이 될 경우 효율x)

3. BPE(Byte pari Encoding)

- 기존 n-gram에서 여러번 나타나는 글자의 나열의 경우, 의미가 있는 것으로 판단해서 따로 token을 만들게 됨 ⇒ BPE

- 반복적으로 나오는 데이터의 연속된 패턴을 치환하는 방식을 사용→ 데이터 효율적 저장이 가능

- → EX) ab⇒ X로 치환, cX ⇒ Y로 치환 ⇒ 문자열 짧게 표현 가능

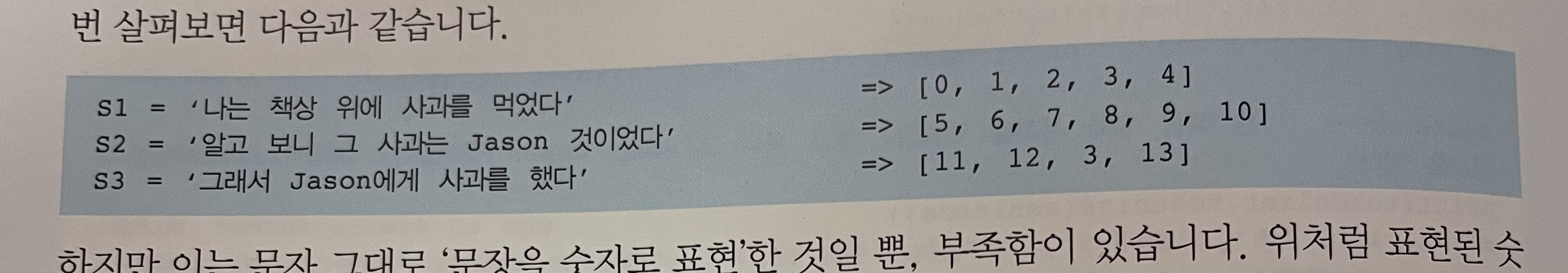

Word Embedding

- 기존 문제점

- 이와 같이 인덱스를 이렇게 설정 후 더하거나 곱했을 때의 문자 인덱스를 보면 문자가 다른 걸 확인할 수 있음

- 이와 같은 방식을 해결하기 위해 나온 것이 원핫 인코딩

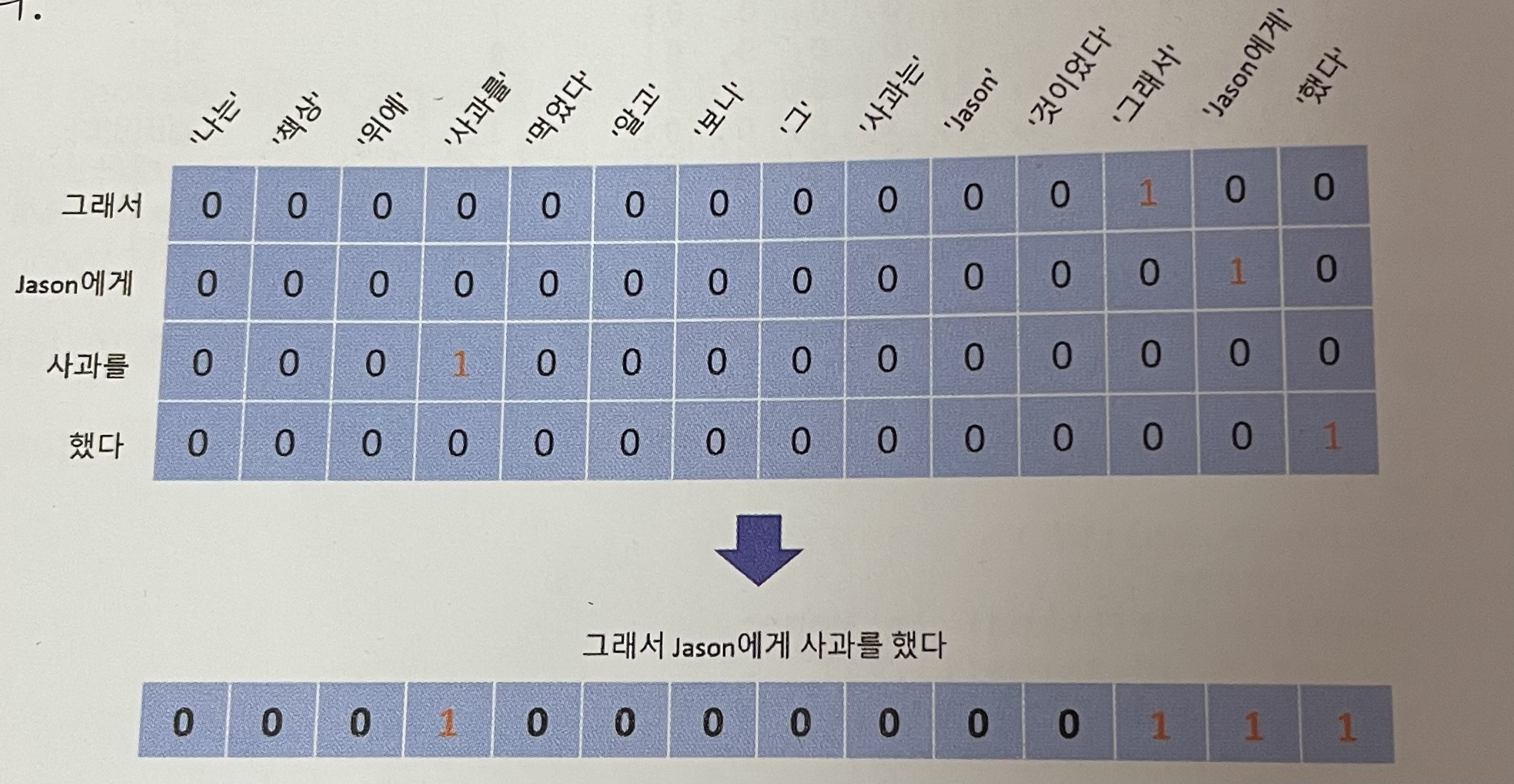

2. Frequency-Based Method

- 단어의 횟수를 기반으로 표현하는 방식을 일컫음

- 문장에 있는 등장 횟수를 세어 표현하는 방식

- 원 핫 인코딩을 거치는 방법

- 문단의 token을 직접 세어서 표현 → 단어 빈도를 이용한 방식

→ 문제점: 관사같은 a, the, of 의 경우, 많이 등장하게 되어 높은 값을 같게 됨 → 빈도가 적은 token에게는 나쁜 영향이 나올 수 밖에 없음

→ 이를 보완하기 위해 나온 것이 IDF(Term Frequency - Inverse Document Frequency)

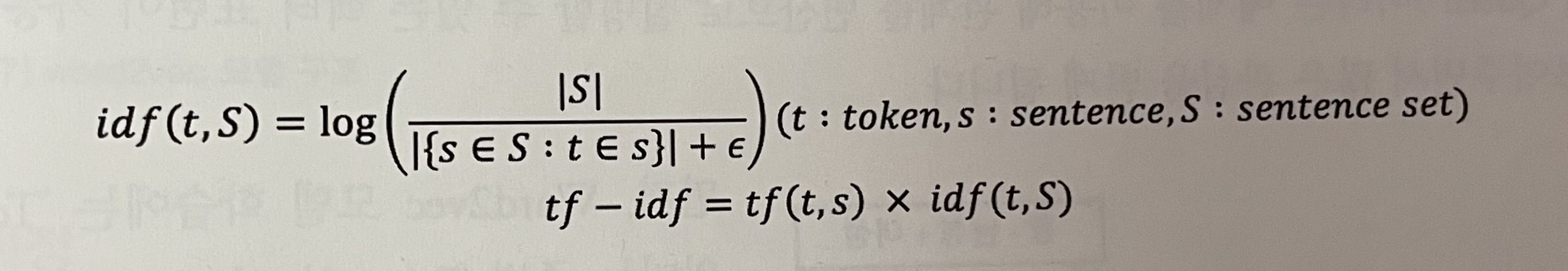

- IDF (Term Frequency- Inverse Document Frequency)

- 전체 corpus 문장 수에서 해당 token이 등장하는 문장 수의 비율의 역수

- 관사의 경우, 빈도수가 높기에 log1에 가까워짐 → 0에 가까운 수

- 따라서 TF * IDF를 곱해줌으로써 TF 수치를 낮춰줌

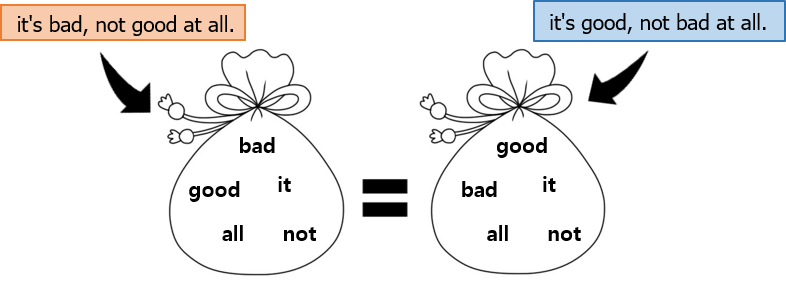

단점: 단어의 출현 횟수만 셀수 있고 단어의 순서는 완전히 무시 된다. 단어의 순서가 무시된다는 것은 다른 의미를 가진 문장이 동일한 결과로 해석될 수 있다는 것이다.

- 횟수 기반의 표현 방식 이기 때문에 동일 결과로 해석할 수도.

3. Dense Representation(희소 표현)

↔ 밀집 표현

- 원-핫 인코딩의 문제점: 변수의 희소성(Sparseness)

- 희소 행렬: 행렬 대부분 값이 0인 경우 ↔ 밀집행렬

- 비효율적임

Word2vec

- 관계를 연산으로 설명할 수 있는 벡터 표현

- token의 의미는 주변 token의 정보로 표현된다

- 특정 token을 기준으로 주변에 비슷한 token이 있다면 해당 token은 비슷한 위치의 벡터로 표현되도록 학습시킴

- 이를 기반으로 나온 방법 2가지 1. cbow, skip-gram

1. CBOW

2. skip-gram

3. GloVe

- LSA는 카운트 기반으로 코퍼스의 전체적인 통계 정보를 고려하기는 하지만, 왕:남자 = 여왕:? (정답은 여자)와 같은 단어 의미의 유추 작업(Analogy task)에는 성능이 떨어집니다.

- Word2Vec는 예측 기반으로 단어 간 유추 작업에는 LSA보다 뛰어나지만, 임베딩 벡터가 윈도우 크기 내에서만 주변 단어를 고려하기 때문에 코퍼스의 전체적인 통계 정보를 반영하지 못합니다.

- GloVe는 이러한 기존 방법론들의 각각의 한계를 지적하며, LSA의 메커니즘이었던 카운트 기반의 방법과 Word2Vec의 메커니즘이었던 예측 기반의 방법론 두 가지를 모두 사용

- 카운트 기반과 예측 기반을 모두 사용하는 방법 → Word2Vec은 예측만 사용

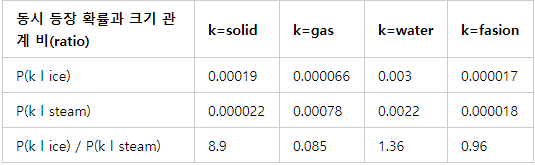

- 임베딩 된 중심 단어와 주변 단어 벡터의 내적이 전체 코퍼스에서의 동시 등장 확률이 되도록 만드는 것

- 학습할 때 동시 등장 행렬을 따로 계산 해줌

- 동시 등장 행렬: 특정 단어가 동시 등장 횟수를 카운트를 하고 특정 단어가 등장했을 때 다른 단어가 등장할 조건부 확률

- 동시 등장 행렬을 활용한 손실함수

4. fasttext

- 서브 워드를 고려해서 학습 ( 하나의 단어 안에도 여러 단어들이 존재하는 것으로 간주) (word2vec와 같은 구조, subword 유무 차이)

- ex) apple, n=3인 경우, <ap, app, ppl, ple, le>, <apple>으로 쪼갬 → 이후 벡터화 진행 후, 벡터값들의 총합으로 구성

→ subwords로 표현하면 oov 에러가 발생할 확률이 적어짐.

→ 학습 때 포함되지 않은 단어들에 대해서도 subwords의 벡터값을 활용하면 의미적으로 유사한 단어끼리 공간상 근접한 위치 값을 같게 됨.

- 이점: ex birthplace(출생지)라는 단어를 학습하지 않은 상태라고 가정

- 만약 다른 단어에서 birth와 place라는 내부 단어가 존재했다면 fasttext는 birthplace의 벡터를 얻을 수 있음.

→ word2vec과 glove의 다른 점이라고 할 수 있음.

5. BERT

- 양방향성을 활용

- 이전 모델들의 경우, 맥락을 왼→오른쪽으로 진행해 문맥 파악.

- ex)

- 사전 학습된 대용량의 레이블링 되지 않는(unlabeled) 데이터를 이용하여 언어 모델(Language Model)을 학습하고 이를 토대로 특정 작업( 문서 분류, 질의응답, 번역 등)을 위한 신경망을 추가하는 전이 학습 방법.

- pre-training이 가능한 모델

어떤 문제에 적용할 수 있을까?

- Question and Answering→ 주어진 질문에 적합하게 대답해야 하는 매우 대표적인 문제입니다. KoSQuAD, Visual QA etc.

- Machine Translation→ 구글 번역기, 네이버 파파고입니다.

- 문장 주제 찾기 또는 분류하기→ 역시나 기존 NLP에서도 해결할 수 있는 문제는 당연히 해결할 수 있습니다.

- 사람처럼 대화하기→ 이와 같은 주제에선 매우 강력함을 보여줍니다.

학습 방법

- next sentence model

- 문장이 올바른 문장인지 맞추는 문제.

- 이를 통해 두 문장 사이의 관계를 학습하게 됨.

- 문장 A와 B를 이어 붙이는데, B는 50% 확률로 관련 있는 문장(IsNext label) 또는 관련 없는 문장(NotNext label)을 사용함.

→ 이런 방식으로 학습된 BERT를 fine-tuning할 때는 (Classification task라면)Image task에서의 fine-tuning과 비슷하게 class label 개수만큼의 output을 가지는 Dense Layer를 붙여서 사용함.

- next sentence model

part 5-3 models

1. RNN

2. LSTM

3. Bi-RNNs

4. GRUS

5. Attention Machanism

6. BERT

'Deep Learning > 2023 DL 기초 이론 공부' 카테고리의 다른 글

| [밑바닥부터 시작하는 딥러닝 1] chap8 딥러닝 (0) | 2023.07.08 |

|---|---|

| [파이썬 딥러닝 파이토치] Part3 (0) | 2023.07.08 |

| [Standford_cs231n] Lecture 2 ) Image Classification (0) | 2023.07.08 |

| [Standford_cs231n] Lecture 3 ) Loss Functions and Optimization (0) | 2023.07.08 |

| [Standford_cs231n] Lecture 4 ) Introduction to Neural Networks (0) | 2023.07.08 |