728x90

반응형

1) 손글씨 숫자 인식 심층 CNN 특징

2) 데이터 확장

3) 층 깊게 하는 이유

4) 대표적 신경망

1. VGG

2. GoogLeNet

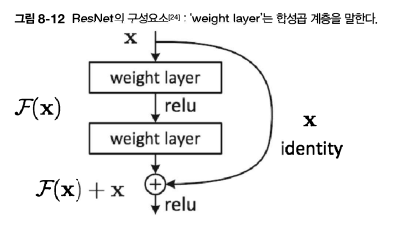

3. ResNet

- 스킵 연결

- 학습에서 층이 너무 많아지면 오히려 학습이 잘 되지 않게 되는 경우 발생

- → 이를 보완한게 ResNet

- 입력 데이터를 합성곱 계층을 건너뛰어 출력에 바로 더하는 구조를 말함

- 입력 x를 두 합성곱 계층을 건너뛰었음

- 따라서 출력값: F(x) + x

- 스킵연결의 경우, 기울기 소실을 막아줌

- 스킵연결은 입력 데이터를 그대로 흘리는 것 → 즉, 역전파 때도 상류의 기울기를 하류에 그대로 보냄 → 따라서 기울기가 작아지거나 커지지 x → 앞 층에 의미 있는 기울기가 전해짐 → 기울기 소실을 막게 해줌

- 전이학습이란?

- 데이터 셋이 적을 때 유용 ex) 기존 데이터 셋으로 학습한 가중치들을 실제 제품에 활용하는 경우

- 학습된 가중치들을 신경망에 미리 복사→ 미리 학습된 가중치를 초깃값으로 설정 → 새로운 데이터셋을 대상으로 재학습.

728x90

반응형

'Deep Learning > 2023 DL 기초 이론 공부' 카테고리의 다른 글

| [파이썬 딥러닝 파이토치] Part2 (0) | 2023.07.08 |

|---|---|

| [밑바닥부터 시작하는 딥러닝 1] chap7(합성곱 신경망) (0) | 2023.07.08 |

| [파이썬 딥러닝 파이토치] Part3 (0) | 2023.07.08 |

| [파이썬 딥러닝 파이토치] Part5 (0) | 2023.07.08 |

| [Standford_cs231n] Lecture 2 ) Image Classification (0) | 2023.07.08 |