728x90

반응형

01 인공지능(딥러닝)의 정의와 사례

1.1 인공지능이란

1.2 인공지능의 사례

- 이미지 분류

- 객체 탐지( 이미지에 포함되어 있는 물체가 뭔지 알아내는거 ex) 쟤는 자동차야)

- 텍스트

- 기계 번역

- 문장 분류

- 질의 응답 시스템

- 개체명 인식

- 알파고

- GAN(Generative Adversarial Networks)

- 고민성씨 컨퍼 프로젝트 같은

- 지들이 output을 만들어내는

- Style Transfer

- 여름 풍경을 겨울 풍경으로

- 이미지 변경?

- deepfake

02 파이토치

03 머신러닝의 정의와 종류

3.1 머신러닝이란

3.2 머신러닝의 종류

- 모델 학습

- 손실함수

3.3 머신러닝의 구분 및 지도학습 모델의 종류

- 지도 학습 VS 비지도 학습 VS 강화학습

1. 지도학습

- 선형 회귀 모델

- 회귀 계수 축소 모델 (Lasso, Ridge, ElasticNet)

- 오히려 변수 많으면 모델 효과 x

- 의사결정나무

- K-NN

- 분류 예측 시에 새로운 데이터 넣고 그 주변 데이터 정보 수합해서 output 추출

- 신경망

- SVM

- 과적합 문제에 대한 해결책 제시 ( 가운데 선 긋는 )

- Ensemble Learning

- bagging

- randomforest

- boosting

- stacking

2. 비지도학습

- 군집화

- 차원 축소법

3. 강화학습

- 알파고

- 현재 상태, 행동, 보상, 다음 상태의 데이터?가 있어야 ⇒ 지도 및 비지도와는 조금 다른 성격

04 과적합

4.1 학습할 샘플 데이터 수의 부족

4.2 풀고자 하는 문제에 비해 복잡한 모델 사용

- 몸무게 예측하는건데 쓸데없이 손톱길이, 팔 길이 이런 변수들까지 있는 경우 (변수 많이 사용)

- 모델 자체가 복잡한 경우(SVM, 딥러닝)

4.3 적합성 평가 및 실험 설계(Training, Validation, Test, Cross Validation)

- 학습 데이터

- 검증 데이터

- 테스트 데이터

- K-Fold Cross Validation

05 인공 신경망

5.1 퍼셉트론

- MLP

- Feed Forward

- Back Propagation

- 활성화 함수(시그모이드)

- 활성화 함수 활용하는 이유: 우리가 풀고자 하는 것이 비선형적인 복잡한 문제라서 비선형 모델로 사용

- 경사 하강법

- Universal Approximation Theorem

- 은닉층이 1개 이상인 신경망은 학습 데이터 내에서 어떤 함수든 근사시킬 수 있다는 이론

- 학습 데이터 내에서 어떤 모델이든 만들 수 있다는

- → 과적합 발생

5.2 신경망 모형의 단점

- 과적합

- 기울기 소실 Gradient Vanishing problem

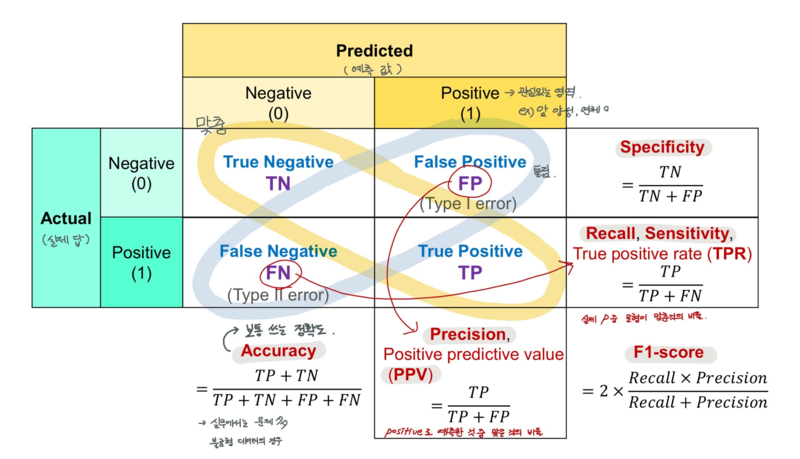

06 성능 지표

728x90

반응형

'Deep Learning > 2023 DL 기초 이론 공부' 카테고리의 다른 글

| [밑바닥부터 시작하는 딥러닝 1] chap3(신경망) (0) | 2023.07.08 |

|---|---|

| [밑바닥부터 시작하는 딥러닝 1] chap6(학습 관련 기술들) (0) | 2023.07.08 |

| [밑바닥부터 시작하는 딥러닝 1] chap7(합성곱 신경망) (0) | 2023.07.08 |

| [밑바닥부터 시작하는 딥러닝 1] chap8 딥러닝 (0) | 2023.07.08 |

| [파이썬 딥러닝 파이토치] Part3 (0) | 2023.07.08 |