728x90

반응형

6-1) 매개변수 갱신

- 신경망 학습의 목적: 손실 함수 값을 낮추는 최적 매개변수를 찾기!

1. 확률적 경사 하강법(SGD)

- W- 학습률과 W에 대한 손실 함수의 기울기 값의 곱

⇒ SGD의 단점: 비등방성 함수에서는 비효율적

- 비등방성 함수 : 각 위치에서의 기울기가 가리키는 지점이 하나가 아닌 여러개.

- 등방성: 어느 방향에서 보아도 똑같은 성질을 가지고 있음

- ex) 홀로그램(보는 방향에 따라 다르게 보이는) ⇒ 비등방성

- 등방성의 예시: 모든 좌표에 대해서 기울기는 항상 중앙을 가르킴

- 비등방성의 예시: 기울기를 가르키는 지점이 여러가지

- y축 방향의 경우, 큼

- x축 방향의 경우 작음

- ⇒ 왔다리 갔다리 하는 폭이 커져버림 ⇒ 시간이 오래걸림

- 지그재그로 움직이는 이유: 최솟값은 0,0 일 때 이지만, 비등방성 함수의 경우, 기울기들이 최솟값 0,0을 가리키지 않음 → 지그재그로(진동이 심하다)

- 곡면의 경우, saddle point(안장점) 에서 학습 종료( 최댓값인 최솟값인지 구분하지 못하고 학습 종료)

- 무작정 기울어진 방향으로 진행된다는 단순한 ⇒ 단점!

- 초록색에서는 최댓값, 파란색에서는 최솟값

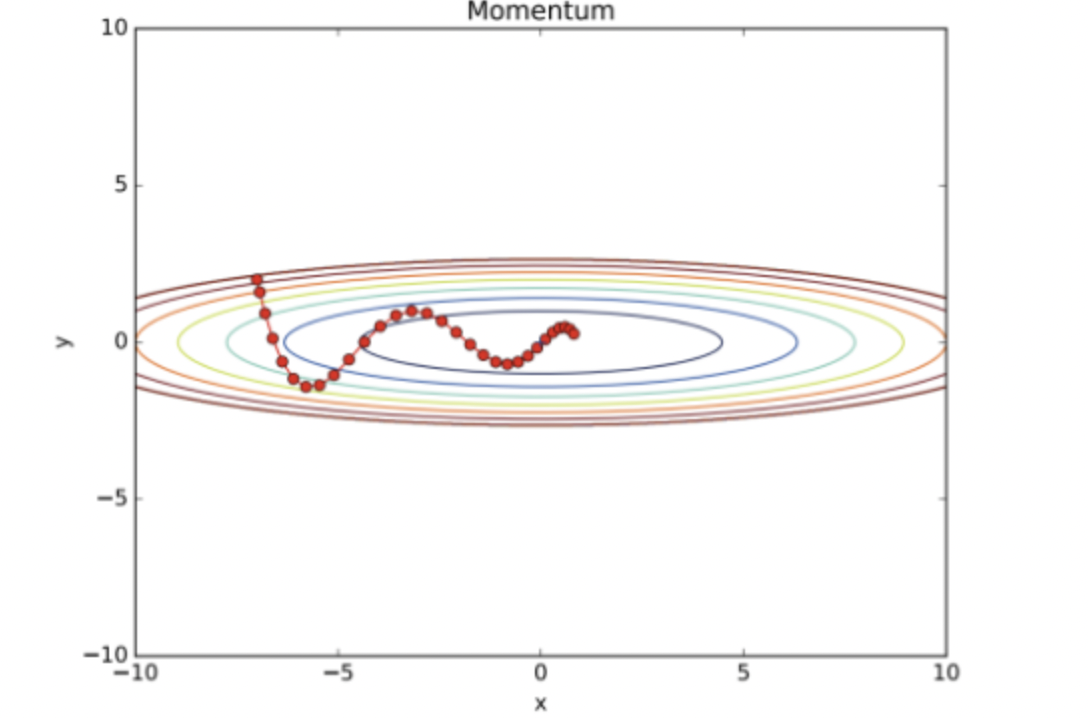

2. 모멘텀(Momentum) (관성 활용)

느린 학습 속도/ saddle point에서 학습 종료/ 진동이 심한 점 (SGD의 단점 보완)

- 운동량을 뜻하는 단어

- p(운동량)= m(질량) * v(속도) → 질량을 1로, 운동량을 속도로만 나타낸다.

- 경사진 곳에서 돌을 굴리면 계속해서 아래로 굴러가려는 성질

- 최솟값을 구하기 용이( 계속 내려가려는 성질이 있기에 최솟값 찾을 수 있음)

- 처음 v는 0으로 초기화

- 기울기 방향으로 힘을 받아 움직이는.

- av: 물체가 아무런 힘을 받지 않을 때 하강시키는 역할(물리에서는 공기 저항을 뜻함)

class Momentum: def __init__(self, lr=0.01, momentum=0.9): self.lr = lr self.momentum = momentum self.v = None def update(self, params, grads): if self.v is None: self.v = {} for key, val in params.items(): self.v[key] = np.zeros_like(val) for key in params.keys(): self.v[key] = self.momentum*self.v[key] - self.lr*grads[key] params[key] += self.v[key]

- 지그재그 정도가 덜해짐

- 계속 내려가는 성질을 보일경우, 쭉 내려가도록( 최솟값 찾는 경우에서도 유용하게 사용)

- 관성을 활용해 극솟값으로부터 빠져나올 수 있음.

overshoooting 문제 발생

- 경사가 가파른 곳을 빠른 속도로 내려오다 관성을 이기지 못하고 최소 지점을 지나쳐 버리는 현상

- 그레디언트가 완만하다면 최적해를 잘 찾겠지만, 가파를수록 overshooting될 가능성이 큼 ⇒ 이를 보완한 알고리즘이 Nesterov momentum

- Nesterov mementum: 오버슈팅을 막기 위해 현재 속도로 한 걸음 미리 가보고 오버 슈팅이 된 만큼 다시 내리막길로 가는 방식.

3. AdaGrad (학습률 감소)

- 이전 경사도를 누적한걸 가지고 곱해서 적응시키는 것

- 오래된 경사도와 최근 경사도를 같은 비중으로 주게 됨 ⇒ 최신 경사도에 좀 더 비중을 두자 ⇒ RMS~

- 신경망 학습의 경우 학습률(learning rate- 보폭) 값 정하는 것이 중요

- AdaGrad: 학습률을 각각 매개변수에 맞춤형 값을 만들어줌( 학습률을 서서히 낮춰주는 방법)

learning rate decay (학습률 감소)

- 초반에는 큰 폭으로 이동하여 최대한 빠르게 내려가고, 점차 학습률을 줄여 조심스럽게 내려가는 방법

adaptive learning rate (적응적 학습률)

- 경사가 가파를 때는 조심스럽게 내려가야하고, 완만할 때는 아까보다 더 성큼성큼 이동할 것임. ⇒ 적응적 학습

- h: 기울기의 제곱

- h에 의해 학습률이 변동됨

- 기울기(변동이 클수록)가 클수록 lr은 낮아짐(sqrt(h))

- y축 방향의 경우, 기울기가 커서 처음에는 크게 움직임

- 이 큰 움직임이 h를 크게 만듬(기울기의 제곱) ⇒ 처음에는 크게 움직이지만, h를 갱신 시키면서 학습률(보폭)을 작게

- → y축 방향으로 갱신 강도가 빠르게 약해짐. 지그재그 움직임도 줄어듦(lr 효과)

- 경사가 완만할 때는 최적해 경로가 아닐 수 있기에 큰 폭으로 이동하는 것이 좋음

- 경사가 가파를 때 큰 폭으로 이동할 경우, 최적화 경로를 벗어나게 됨(최소 지점을 벗어나는)

많이 변화한 변수는 최적해에 근접했을 거란 가정 하에 작은 크기로 이동하면서 세밀하게 값을 조정, 적게 변화한 변수들은 학습률을 크게 해 빠르게 오차 값을 줄이고자 함.

class AdaGrad: def __init__(self, lr=0.01): self.lr = lr self.h = None def update(self, params, grads): if self.h is None: self.h = {} for key, val in params.items(): self.h[key] = np.zeros_like(val) for key in params.keys(): self.h[key] = grads[key] * grads[key] params[key] -= self.lr * grads[key]/(np.sqrt(self.h[key] + 1e-7)- le-7 h가 0일 때도 0으로 나누는 사태 방지

AdaGrad의 단점 보완) → RMSProp

기존 AdaGrad는 과거의 기울기의 제곱을 계속 더하게 되면 어느 순간 0이 되어버림 ⇒ 갱신을 하지 않게 됨.( lr이 점점 작아지게 되므로(기울기가) 계속 곱하게 되면)

- 경사가 매우 가파른 곳에서(변화가 큰 경우) 학습을 하게 되면, 초반부터 학습률이 감소하게 됨 ⇒ 최적에 도달하기 전에 조기 종료될 가능성. ⇒ 조기 학습 중단 문제 해결= RMSProp

- RMSProp은 과거의 기울기를 잊고, 새로운 기울기 정보를 크게 반영 ⇒ 지수이동평균

- 과거 기울기의 반영 규모를 감소시킴

- RMSProp 의 장점은 미분값이 큰 곳에서는 업데이트 할 때 큰 값으로 나눠주기 때문에 기존 학습률 보다 작은 값으로 업데이트됨 → 진동 줄이는데 도움 됨.

- 반면 미분값이 작은 곳에서는 업데이트시 작은 값으로 나눠주기 때문에 기존 학습률 보다 큰 값으로 업데이트됨.

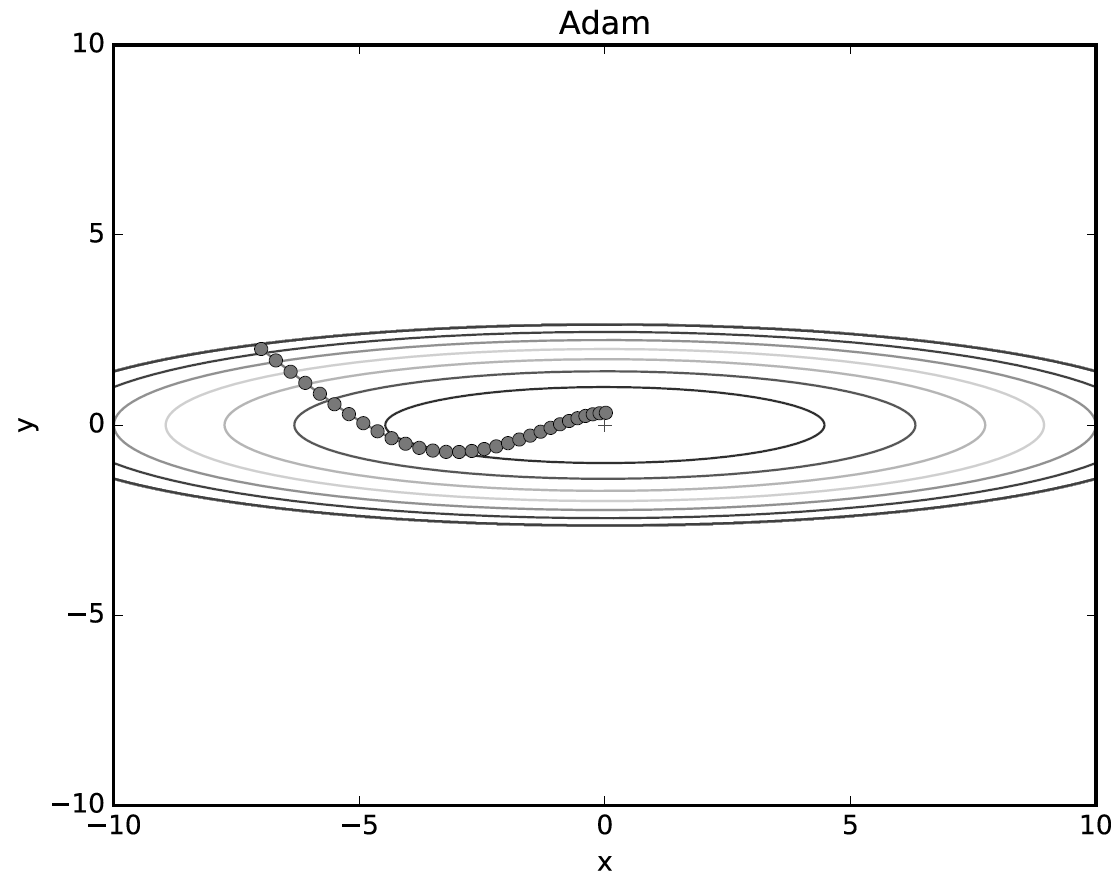

4. Adam (2+3+ 편향 보정)

- 모멘텀 + AdaGrad + 하이퍼 파라미터의 편향 보정도 가능

- 모멘텀에서 사용하는 계수와 학습률에 대한 계수가 사용

- 학습률을 줄여나가고 속도를 계산하여 학습의 갱신강도를 적응적으로 조정

class Adam: def __init__(self, lr=0.001, beta1=0.9, beta2=0.999): self.lr = lr self.beta1 = beta1 self.beta2 = beta2 self.iter = 0 self.m = None self.v = None def update(self, params, grads): if self.m is None: self.m, self.v = {}, {} for key, val in params.items(): self.m[key] = np.zeros_like(val) self.v[key] = np.zeros_like(val) self.iter += 1 lr_t = self.lr * np.sqrt(1.0 - self.beta2**self.iter) / (1.0 - self.beta1**self.iter) for key in params.keys(): #self.m[key] = self.beta1*self.m[key] + (1-self.beta1)*grads[key] #self.v[key] = self.beta2*self.v[key] + (1-self.beta2)*(grads[key]**2) self.m[key] += (1 - self.beta1) * (grads[key] - self.m[key]) self.v[key] += (1 - self.beta2) * (grads[key]**2 - self.v[key]) params[key] -= lr_t * self.m[key] / (np.sqrt(self.v[key]) + 1e-7) #unbias_m += (1 - self.beta1) * (grads[key] - self.m[key]) # correct bias #unbisa_b += (1 - self.beta2) * (grads[key]*grads[key] - self.v[key]) # correct bias #params[key] += self.lr * unbias_m / (np.sqrt(unbisa_b) + 1e-7)- Adam의 하이퍼 파라미터: 3개

- 학습률

- 일차 모멘텀용 계수 B1, 2차: B2

- B1은 0.9로, B2는 0.999

6-2) 가중치의 초깃값(gradiant vanishing 한계)

- 사용 이유: 각 neuron의 가중치를 기반으로 error를 결정하기 때문이고, 정확한 모델을 얻으려면 작은 error를 필요로 하기 때문

- 신경망을 학습할 때 모델 초기화는 손실 함수에서 출발 위치를 결정하며, 특히 가중치 초기화는 학습 성능에 크게 영향을 미침

- 신경망의 가중치를 0으로 초기화하면 학습이 진행되지 않음

- 신경망의 가중치를 0이 아닌 상수로 초기화하면 같은 계층에 있는 뉴런은 마치 하나의 뉴런만 있는 것처럼 작동함.

- 따라서 신경망의 가중치는 모두 다른 값으로 초기화해야 하며, 일반적으로 난수를 이용해서 초기화함

1. 가중치 감소(weight decay)

- 가중치 매개변수 값이 작아지도록 학습하는 방법

- 가중치 값을 작게 해서 오버피팅이 발생하지 않도록 함

- 가중치가 0이면 가중합 결과는 항상 0이 됨.

- 활성화 함수의 경우, 가중 합산 결과인 0을 입력 받아 항상 같은 값을 출력하게 됨

- 결론: 의미가 없다

- (가중치 크게) 가중치 표준편차가 1인 정규분포로 초과할 경우

- 활성화 값들이 0과 1에 치우쳐 있음

- (시그모이드) 얘네들을 미분하면 결국에 0으로 됨. → 결국 기울기 소실 발생 (역전파시)

- (가중치 작게) 표준편차를 0.01로 할 경우

- 그래프가 거의 동일한 형상을 나타냄 ⇒ 뉴런이 거의 같은 값을 출력 → 의미가 없다

- 따라서, 각 층의 활성화 값들은 적당히 분포되어 있어야 한다

6-2-1). Xavier 초깃값(sigmoid, tanh)

6-2-2). He 초깃값(ReLU)

6-2-3) 배치 정규화(순전파에서 적용)

6-3) 올바른 학습을 위해

6-4-1) 오버피팅(억제 방법: 가중치 감소, 드롭 아웃)

- 매개변수가 많고 표현력이 높은 모델

- 훈련 데이터가 적을 때 발생

6-4-2) 가중치 감소(weight decay)

- 큰 가중치에 대해 패널티 부과

- 패널티 부과(L1,L2,L무한대)

- 모든 가중치 각각의 손실 함수에 1/2*람다*W^2를 곱함

- 가중치 기울기를 구할 경우, 람다*W를 더함

- 람다: 정규화 세기를 조절하는 하이퍼 파라미터( 크게 설정할수록 큰 가중치에 대한 패널티가 커짐)

6-4) 적절한 하이퍼 파라미터 찾기

- 뉴런 수, 배치 크기, 매개변수 갱신 시의 학습률과 가중치 감소

- 검증 데이터 활용

- 하이퍼 파라미터 최적화

0단계: 하이퍼 파라미터 값의 범위 설정

1단계: 설정된 범위에서 하이퍼파라미터의 값을 무작위로 추출

2단계: 1단계에서 샘플링한 하이퍼파라미터 값을 사용하여 학습, 검증 데이터로 정확도 평가( 에폭은 작게)

3단계: 1단계,2단계를 특정 횟수 반복, 정확도의 결과를 보고 파라미터 범위를 좁힘

- 베이지안/그리드/랜덤 서치

728x90

반응형

'Deep Learning > 2023 DL 기초 이론 공부' 카테고리의 다른 글

| [밑바닥부터 시작하는 딥러닝 1] chap4(신경망 학습) (0) | 2023.07.08 |

|---|---|

| [밑바닥부터 시작하는 딥러닝 1] chap3(신경망) (0) | 2023.07.08 |

| [파이썬 딥러닝 파이토치] Part2 (0) | 2023.07.08 |

| [밑바닥부터 시작하는 딥러닝 1] chap7(합성곱 신경망) (0) | 2023.07.08 |

| [밑바닥부터 시작하는 딥러닝 1] chap8 딥러닝 (0) | 2023.07.08 |