728x90

반응형

1. Intro

- 같은 read라고 해도 현재형과 과거형이 있음 -> 앞에서만 예측을 해서 출력하면 정확히 모르기 때문에, 뒤에서부터 오는 애들을 가지고 예측을 해서 read가 과거형으로 쓰인다! 라고 알려주는게 엘모의 역할

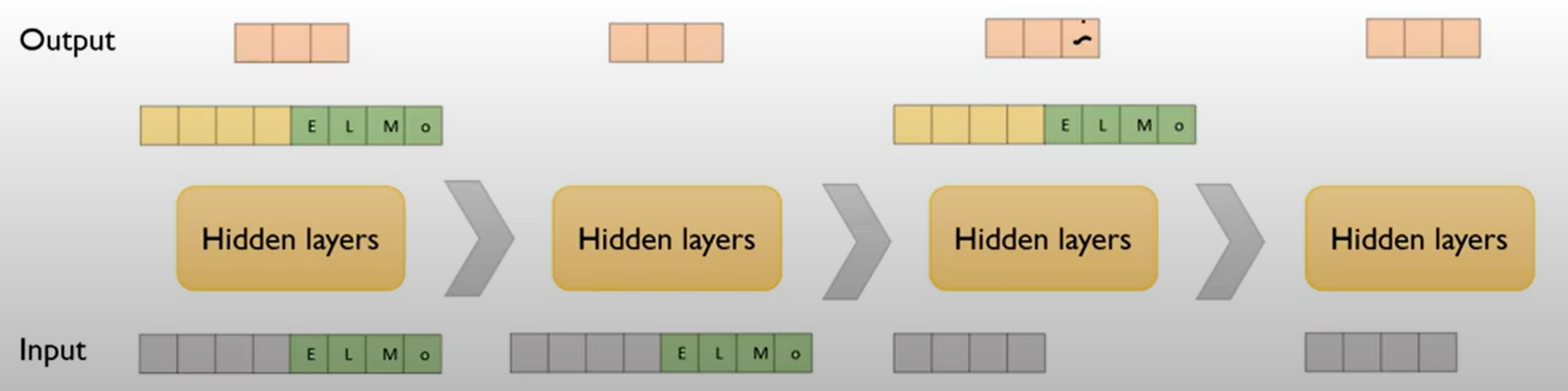

2. Overall architecture

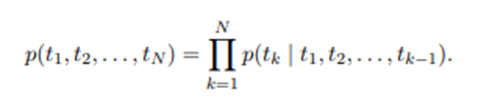

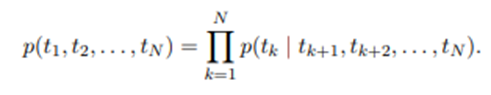

3. Bidirectional language models (biLM)

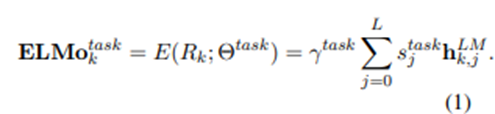

4. ELMo

7. Outro

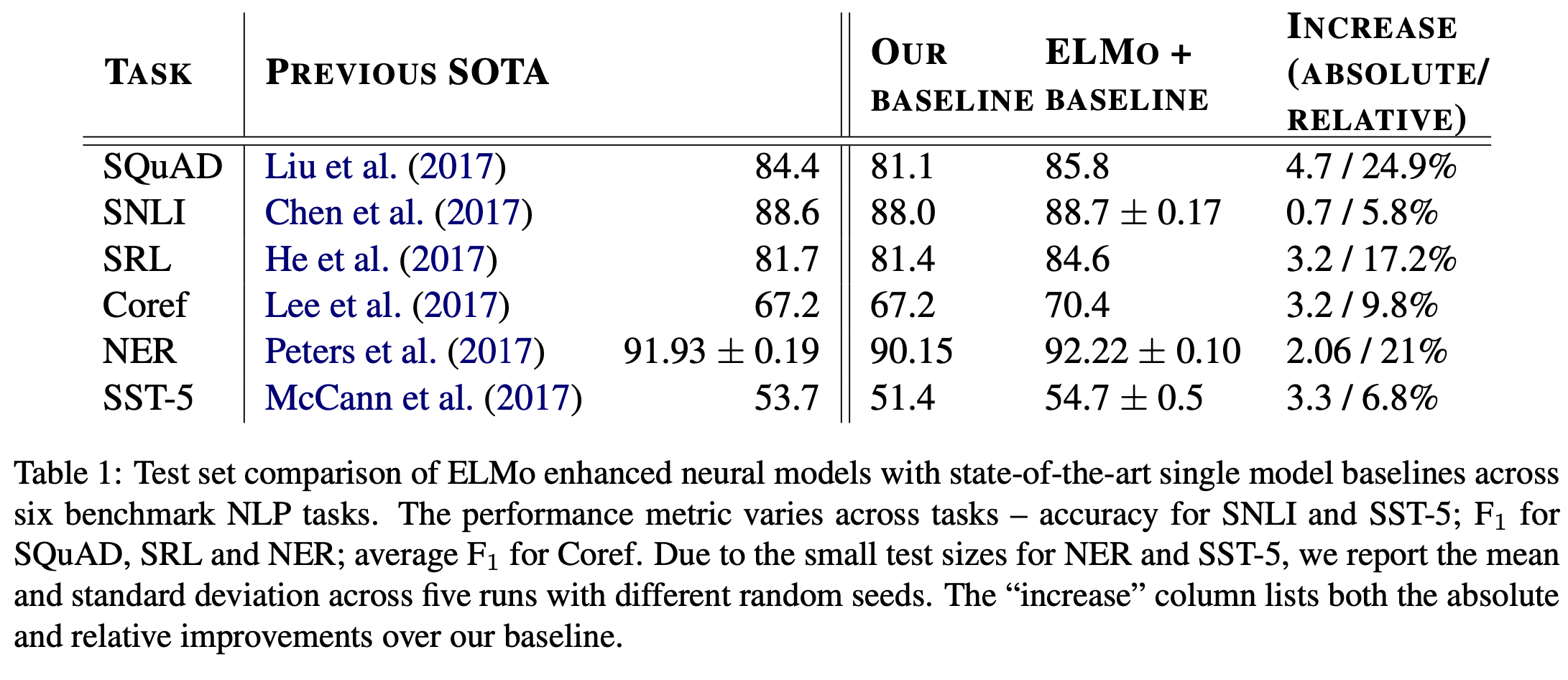

- biLM을 사용해 높은 수준의 context를 학습하는 ELMo model을 제안함.

- ELMo model을 사용하면 대부분의 NLP task에서 성능이 향상됨.

- layer의 층이 올라갈수록 syntax보다는 semantic한 정보를 담아낸다는 사실도 발견해냄.

- 때문에 어느 한 layer를 사용하는 것보다는 모든 layer의 representation을 결합해 사용하는 것이 전반적인 성능 향상에 도움이 된다는 결론을 내릴 수 있음.

728x90

반응형

'Deep Learning > [논문] Paper Review' 카테고리의 다른 글

| Transformer (0) | 2023.07.06 |

|---|---|

| Inception V2/3 (0) | 2023.07.06 |

| SegNet (0) | 2023.07.06 |

| CycleGAN (0) | 2023.07.05 |

| XLNet: Generalized Autoregressive Pretraining for Language Understanding (1) | 2023.07.05 |